Suscripción al boletín

Introduzca su dirección de correo electrónico y suscríbase a nuestro boletín.

Introduzca su dirección de correo electrónico y suscríbase a nuestro boletín.

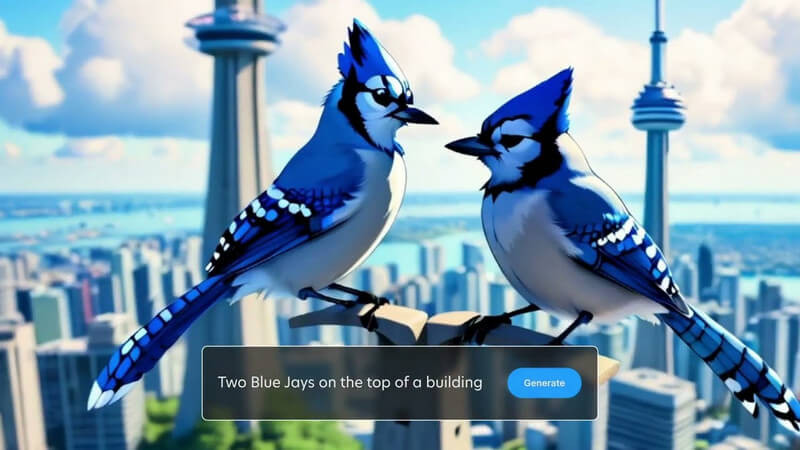

Es posible que ya sepa cómo crear imágenes generadas por IA con la ayuda de Stable Diffusion. Ahora también puedes darle una nueva vida a esas imágenes con gráficos en movimiento generados por IA. Bienvenido a Estable Video Difusión que puede ayudarte a convertir tus imágenes estáticas en videos dinámicos. En este post te contaré todo lo importante sobre el Generación de vídeo de difusión estable y cómo puedes usarlo como un profesional.

Como sabe, Stable Diffusion es un modelo de IA de código abierto creado por Stability AI. Con Stable Diffusion, puede generar imágenes simplemente ingresando mensajes de texto. Ahora, con la versión de vídeo de Stable Diffusion, puedes convertir tus imágenes en vídeos cortos de forma gratuita.

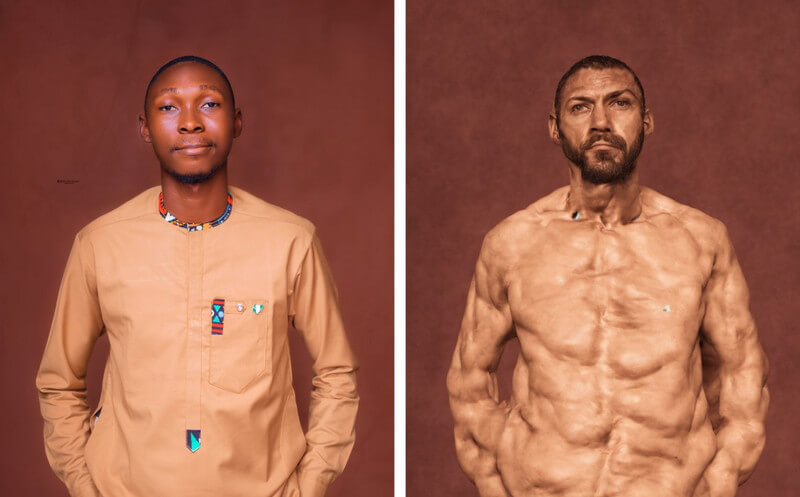

El modelo de IA toma la imagen como fotograma fuente y crea fotogramas posteriores utilizando una técnica única, que se conoce como difusión. Idealmente, la técnica agrega varios detalles (ya sea para el fondo o el objeto) a una imagen fuente, convirtiéndola en un video. Stability AI ha entrenado el modelo basándose en un gran conjunto de vídeos y fotografías realistas, que pueden ejecutarse virtualmente o en un sistema local.

En general, Difusión de vídeo estable es una poderosa herramienta que puede ayudarte a crear todo tipo de videos, desde contenido creativo hasta educativo. Si bien se lanzó recientemente, el modelo aún está en desarrollo y se espera que evolucione en el futuro.

Actualmente, puede utilizar la función de vídeo de Stable Diffusion de dos maneras: puede instalarla en su sistema o aprovechar cualquier aplicación basada en web.

Desde Vídeo a vídeo con IA de difusión estable gratis La solución es una oferta de código abierto, varias herramientas de terceros la han integrado en sus plataformas. Por ejemplo, puede visitar el sitio web: https://stable-video-diffusion.com/ y sube tu foto. Una vez cargada la foto, la herramienta la analizará automáticamente y la convertirá en un vídeo.

¡Eso es todo! En unos segundos, la herramienta online generará un vídeo corto basado en la foto cargada. Simplemente puede obtener una vista previa del video aquí y descargarlo en su sistema.

Si desea obtener resultados más personalizados (y sin filtrar), también puede considerar instalar el módulo AI desde Vídeo estable Difusión en su sistema. Sin embargo, debes saber que el proceso es un poco técnico y consumirá importantes recursos informáticos.

Requisitos previos:

Una vez que haya cumplido con los requisitos anteriores, puede iniciar la consola de Python en su sistema. Ahora, puede ejecutar los siguientes comandos uno por uno, que crearán, activarán e instalarán las dependencias necesarias en su sistema para ejecutar Stable Diffusion.

python3 -m venv venv

fuente venv/bin/activar

instalación de pip -r requisitos.txt

Una vez que el entorno esté funcionando en su sistema, puede preparar una imagen de entrada. Si no tiene una imagen, puede usar la IA de difusión estable estándar para crear una ingresando texto.

Para generar el vídeo, simplemente puede navegar por el difusión-de-video-estable dirección en su sistema. Simplemente ingrese el siguiente comando para generar el video, usando una imagen de entrada:

python3 scripts/dream.py –ckpt_path ckpt/stable-diffusion.ckpt –image_path input_image.png –prompt “texto rápido” –fps 6 –num_frames 100 –augmentation_level 0.5

Tenga en cuenta que en el comando anterior, debe hacer lo siguiente:

Después de ingresar el mensaje, puede esperar un momento mientras el Generación de vídeo de difusión estable completa su procesamiento. Si el proceso es más complejo, es posible que Stable Diffusion tarde un poco en generar sus resultados.

Una vez que se complete la generación del video, se guardará en el producción directorio con la marca de tiempo como nombre.

De esta manera, puedes utilizar el Vídeo a vídeo con IA de difusión estable gratis (o foto a video gratis) herramienta para generar videos. Puede experimentar más con varias indicaciones y configuraciones de entrada para modificar los resultados.

En pocas palabras, la difusión estable es una modelo de IA creado por Stability AI para generar contenido multimedia de alta calidad (fotos y videos). Es una versión más estable de sus modelos anteriores, que genera imágenes realistas y sin errores.

Por otro lado, Unstable Diffusion es su contraparte más creativa y sin restricciones. A diferencia de Stable Diffusion, que se entrenó en un conjunto de datos de imágenes filtradas, Unstable Diffusion tiene imágenes sin filtrar como conjunto de datos. Por eso, la difusión inestable a menudo puede provocar errores en sus resultados y produce un trabajo más abstracto que realista.

Desde Difusión de vídeo estable todavía está evolucionando, es difícil predecir su impacto real, pero puede tener la siguiente influencia:

Como sabes, Stable Diffusion puede generar vídeos en segundos, lo que puede ayudar a los creadores de contenido a ahorrar tiempo. Puede crear animaciones, agregar efectos especiales o transferir estilos de videos al instante en lugar de pasar horas editando.

Los esfuerzos manuales que ponemos en la edición de videos pueden ser costosos y llevar mucho tiempo. Por otro lado, Difusión de vídeo estable puede ayudarlo a reducir estos costos de edición al automatizar la mayoría de las tareas de posproducción.

Los creadores ahora pueden crear videos más allá de su creatividad restringida con Stable Diffusion. Por ejemplo, se puede utilizar para generar vídeos con efectos especiales realistas o para animar imágenes fijas.

Como mencioné anteriormente, Stable Diffusion es una herramienta de código abierto, que está disponible gratuitamente para cualquier persona. Esto lo convierte en un activo creativo valioso para cualquiera que quiera crear vídeos, independientemente de sus habilidades o presupuesto.

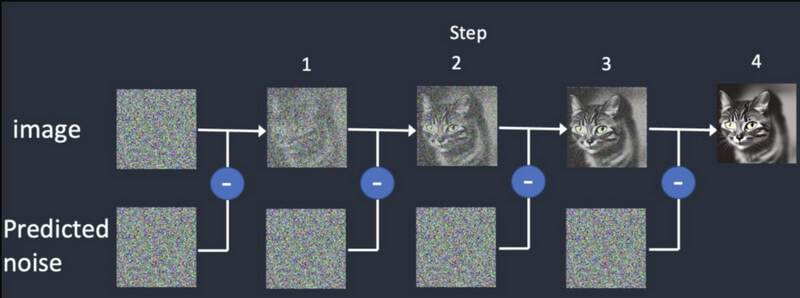

Como sugiere el nombre, el modelo de IA se basa en una práctica de difusión que entrena la inteligencia artificial para generar medios realistas. Se basa en tres grandes principios:

Difusión: En difusión, primero comenzamos con una imagen aleatoria y luego le agregamos más detalles gradualmente. Seguirá proporcionando diferentes resultados hasta que coincida con la entrada inicial. Esto entrenará al Generación de vídeo de difusión estable idear monturas sintéticas, basadas en la inicial.

Capacitación: Al igual que una imagen, el modelo de difusión se entrena en un conjunto de datos masivo. De esta forma, el modelo de IA puede distinguir y generar fácilmente todo tipo de objetos realistas.

Generación de vídeo: Una vez entrenado el modelo, los usuarios pueden cargar una imagen en el modelo de IA. El modelo refinará el ruido de cada cuadro y generará resultados realistas, basados en las entradas proporcionadas para colores, rotaciones, cambios visuales, etc.

Difusión de vídeo estable es un lanzamiento reciente y tiene varias limitaciones, incluidas las siguientes:

La buena noticia es que el modelo actual de IA del Difusión de vídeo estable está disponible de forma gratuita. Según Stability AI, a partir de ahora ha desarrollado el modelo con fines de investigación. Puede acceder al código del modelo en su página de GitHub aquí: https://github.com/Stability-AI/generative-models

Además de eso, puedes acceder a su documentación sobre Hugging Face aquí: https://huggingface.co/stabilityai/stable-video-diffusion-img2vid-xt

La propia Stability AI ha realizado una extensa investigación y ha comparado su modelo de generación de vídeo con otras herramientas. Según la investigación, Stable Video Diffusion se compara con modelos como Runway y Pika Labs.

Aquí puede ver cómo funcionan estos modelos para generar 14 y 25 fotogramas a una velocidad personalizada de 3 a 30 fps. Stable Diffusion también es más potente en comparación con Google Video Diffusion y DALL.E cuando se trata de generar vídeos realistas.

| Modelo | Fortaleza | Debilidad |

| Difusión de vídeo estable | Resultados realistas y coherentes, buenos para vídeos cortos a partir de imágenes fijas. | Longitud limitada, variaciones de calidad, control creativo limitado. |

| Difusión de vídeos de Google | Puede generar videos más largos, bueno para la generación de texto a video | Puede producir errores, requiere ajustes (no tan estable) |

| DALL-E 2 | Altamente creativo y experimental. | Puede ser menos estable |

| Pista ML | Fácil de usar y bueno para principiantes. | Capacidades limitadas y no tan potentes como otros modelos. |

| Laboratorios Pika | Fuente abierta | Base de usuarios limitada, aún en desarrollo |

No – a partir de ahora, los resultados de la Generación de vídeo de difusión estable. están limitados a hasta 4 segundos únicamente. Sin embargo, en las próximas versiones de esta IA, podríamos esperar que también genere vídeos de larga duración.

Estos son algunos de los requisitos para correr. Difusión de vídeo estable:

| Requisito | Mínimo | Recomendado |

| GPU | 6 GB de RAM | 10 GB de VRAM (o superior) |

| UPC | 4 núcleos | 8 núcleos (o superior) |

| RAM | 16 GB | 32 GB (o superior) |

| Almacenamiento | 10GB | 20 GB (o más) |

Además de eso, debes instalar Python 3.10 (o superior) en tu sistema de antemano.

Actualmente, Stability AI solo ha lanzado Difusión de vídeo estable con fines de investigación para que el modelo pueda evolucionar. Sin embargo, en el futuro, podríamos esperar que el modelo de IA evolucione con las siguientes características:

Estoy seguro de que después de leer este post, podrás entender fácilmente cómo Generación de vídeo de difusión estable obras. También se me ocurrieron algunos pasos rápidos que puedes seguir para comenzar. Difusión de vídeo estable por tu cuenta. Aunque debes recordar que el modelo de IA es relativamente nuevo, todavía está aprendiendo y es posible que no cumpla con sus requisitos exactos. ¡Adelante, prueba el modelo de vídeo generativo Stability AI y sigue experimentando con él para dar rienda suelta a tu creatividad!